Student Theses

On the following pages you can find lists of Student Theses of our Institute. The lists show Student Theses which are in progress or already finished.

Open topics

|

Bachelor thesis

Intraoperative Erfassung der Beckenkippung mittels Handy-Sensoren

Ziel dieser Arbeit ist es, die Sensoren eines aktuellen (Highclass-)Handys möglichst optimal zu kombinieren, um die Winkelmessung in allen drei Achsen möglichst präzise durchführen zu können. Darüber hinaus soll eine App programmiert werden, die es dem Anwender die Ausrichtung der Beckeneingangsebene sowohl im stehen als auch im liegen zu erfassen. Die Winkelwerte können gespeichert und verglichen werden. So wird eine Kippung des Beckens sichtbar. Wird anschließend noch die Ausrichtung des anatomischen Acetabulum im Becken erfasst, stehen alle zur Implanation eines Pfannenimplantats gewünschten Informationen zur Verfügung.

Betreuer: Daniel Brandes |

In progress

|

Master thesis

Nils Hein

Differentialgeometrische Analyse von Power Flow und Power Grid Berechnungen

Im Kontext elektrischer Energietechnik befasst sich die Power Flow- bzw. die Power-Grid-Analyse mit der Energieversorung in komplexen Netzwerken. Übliche Herangehensweisen sind häufig algebraischer Natur und skalieren deswegen schlecht. Insbesondere in hochdimensionalen Parameterräumen sind die Berechnungen sehr aufwändig und numerisch problematisch. Ziel dieser Arbeit ist die Untersuchung differentialgeometrischer Verfahren im Hinblick auf verschiedene Beispiele aus dem Power-Flow Bereich. Dabei soll insbesondere untersucht werden, wie kompetitiv der differentialgeometrische Ansatz ist und was die Grenzen dieser Herangehensweise sind. Betreuer: Maximilian Klein April 2017

|

|

Bachelor thesis

Karl Hasselbring

Hochperformante Datenstrukturen für persistente Compound Graphen

Im Rahmen meiner Forschung an dem Code-Generierungs-Tool Buggy werden spezielle Compound-Graphen verwendet, die neben der Graphstruktur auch noch eine Hierarchie aufbauen. Diese wird durch Compound Knoten realisiert. Dies sind Knoten die selber wieder Graphen enthalten können. Dazu gibt es mehrere Layer von Kanten die entweder über spezifische Ports verbunden sind oder aber Knoten direkt verbinden. Die Graph Implementierung (zu finden unter https://github.com/BuggyOrg/graphtools) hat dafür einige Anfrage-Möglichkeiten die das Arbeiten mit den Graphen erleichtern soll. Die ganzen Operationen sind dafür persistent implementiert, das heißt nach außen hin scheinen die Graphen immutable zu sein. Dies hat für uns den Vorteil, dass Operationen leicht nachvollziehbar bleiben und Fehler meist einfach zu identifizieren sind. Zum sicherstellen der immutability werden momentan alle Graphen für jede Operation kopiert. Dies ist sehr aufwändig und kann eindeutig verbessert werden. Ziel dieser Bachelorarbeit ist das Entwickeln von Algorithmen zum effizienten Bearbeiten und Anfragen in oben vorgestellten Compound Graphen. Dazu sollen existierende Verfahren zum Erzeugen von effizienten persistenten Datenstrukturen evaluiert werden und an die Bedürfnisse des existierenden Graphen angepasst werden. Betreuer: Maximilian Klein April 2017

|

|

Bachelor thesis

Elias Entrup

Emergente Array-Typisierungen in algebraischen Datentypen

Algebraische Datentypen schaffen sind eine elegante Beschreibung von Datentypen, die stark das Konzept rekursiver Definitionen ausnutzen. Algorithmen, die solche Datentypen verwenden ähneln in der Struktur stark der Datenstrukturdefinition und führen so zu meistens gut nachvollziehbaren Code. Die Umsetzung solcher algebraischer Datentypen in ausführbaren Programmen ist direkt ableitbar aus deren Definition und basiert meist aus verlinkten Strukturen. Genau diese Interpretation der Datenstrukturen (als verlinkte Strukturen) führt jedoch häufig zu schlechteren Laufzeiten. Das dereferenzieren von Pointern ist eine teure Operation, da diese den Cache einer CPU nicht ausnutzen kann. Um die elegante Struktur von algebraischen Datentypen zu erhalten und dennoch performante Programme erzeugen zu können, wäre eine Analyse der Datenstruktur denkbar, die versucht die verlinkten Strukturen durch Arrays zu ersetzen (wo möglich). Diese Bachelorarbeit soll genau solche Fälle untersuchen und das Optimierungspotential von Ersetzungssystemen analysieren. Betreuer: Maximilian Klein April 2017

|

|

Master thesis

Pascal Urban

Automatisches Erzeugen von parallelen Programmen

Das Schreiben von parallelem Code ist meist ein aufwändiges und fehlerträchtiges Vorhaben. Moderne Programmiersprachen arbeiten oft imperativ und sind objektorientiert. Beides sind Paradigmen, die das Parallelisieren erschweren. Einerseits weil der Kontrollfluss nicht explizit gegeben ist. Andererseits, weil die Daten, die verarbeitet werden nicht explizit modelliert werden, sondern durch Paradigmen wie "Hidden State" abstrahiert werden. Es existieren andere Ansätze, wie z.B. die von der Programmiersprache Go verwendeten Channels, die aus Hoares CSP (Communicating Sequential Processes) hervorgingen. Prozessalgebren wie CSP oder CCS starten direkt mit der Annahme von parallel arbeitenden Prozessen und modellieren den Datenfluss (aus dem eine Art Kontrollfluss direkt ableitbar ist). Das am Institut entwickelte System "Buggy" arbeitet intern gerade mit der Semantik von CSP und garantiert damit eine transparente Situation in der das Erzeugen parallelen Codes zunächst eine einfache Folgerung aus den Regeln von CSP sind. Dies führt dazu, dass jede Operation sinnvoll parallelisiert werden kann. Das parallelisieren jeder einzelnen Operation würde jedoch zu einem zu großen Overhead führen. Ziel dieser Masterarbeit ist es, das Generieren von parallelen C-Code zu ermöglichen, mit dem Ziel die Programme möglichst effizient zu machen. Dabei sollen verschiedene Heuristiken erarbeitet werden, die entscheiden, wann welche Parallelisierungsvarianten (wie z.B. Pipelining) angewandt werden. Betreuer: Maximilian Klein Januar 2017

|

Finished

| 2017 | ||||||

|

Master thesis

Jan Jamaszyk

Leibniz Universität Hannover

Implementierung eines Self-Sensing-Konzepts in die Ansteuerung eines Taktilen Displays

Beschreibungstext anzeigen

Im Rahmen eines DFG-Projektes entwickeln das Welfenlab, das IDS und das IMPT ein taktiles Display, das das Ertasten von unterschiedlichen virtuellen Oberflächenstrukturen wie Textilien, Leder, Holz und Kunststoffen ermöglichen soll. Für die taktile Wahrnehmung ist eine Vielzahl von unterschiedlichen, sich im Finger befindlichen Mechanorezeptoren zuständig. Jeder Rezeptortyp reagiert auf bestimmte Reize und Anregungsfrequenzen besonders sensibel. Um taktile Oberflächeneindrücke möglichst exakt nachbilden zu können, muss eine gezielte Anregung dieser unterschiedlichen Rezeptoren erfolgen. Dazu bedarf es neben der mechanischen Aktorik auch eines geeigneten Ansteuerungsmodells und einer gezielten Steuerung. Die Modellierung einer konsistenten Ansteuerung hängt unter anderem auch von dem Systemverhalten des Displays sowie der mechanischen Impedanz der Fingerkuppe ab und ist im Allgemeinen nicht a priori bekannt. Insbesondere individuelle Unterschiede im Gewebeverhalten des Fingers und der variable Anpressdruck auf das Display können im bereits bestehenden System zurzeit nicht erfasst werden und erschweren damit die Vergleichbarkeit der Eindrücke zwischen verschiedenen Benutzern. Ziel dieser Arbeit ist der Entwurf und die Implementierung einer Erweiterung des bestehenden Systems, die es erlaubt während der Benutzung des Displays Impedanzmessungen durchzuführen und durch regelungstechnische Maßnahmen individuelle Unterschiede zwischen den Anwendern auszugleichen. Als Grundlage für diese Messungen soll das Prinzip des "Self-Sensings" genutzt werden, welches es erlaubt aus Strom- und Spannungsvariationen an einem piezoelektrischen Biegeaktor Rückschlüsse auf die anliegenden Kräfte und Geschwindigkeit zu ziehen. Teil dieser Arbeit ist der Entwurf einer Verstärkerschaltung, welche den Anforderungen an die Betriebsspannung des eingesetzten Biegeaktors genügt, sowie der Entwurf und die softwareseitige Implementierung einer aktiven Kompensation über einen Mikrocontroller. Im Rahmen dieser Arbeit ergeben sich insbesondere die folgenden Aufgabenpunkte:

Betreuer: Andreas Tarnowsky Januar 2016

Juli 2017

|

||||||

|

Master thesis

Nicola Gruhl

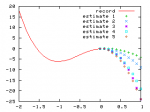

Grundlangen zur differentialgeometrischen Analyse von Power Flow und Power Grid Berechnungen

Beschreibungstext anzeigen

Im Kontext elektrischer Energietechnik befasst sich die Power Flow- bzw. die Power-Grid-Analyse mit der Energieversorung in komplexen Netzwerken. Übliche Herangehensweisen sind häufig algebraischer Natur und skalieren deswegen schlecht. Insbesondere in hochdimensionalen Parameterräumen sind die Berechnungen sehr aufwändig und numerisch problematisch. Ziel dieser Arbeit soll eine grundlegende differentialgeometrische Untersuchung des Problems sein. DIe hierraus resultierenden numerischen Methoden haben in natürlicher Weise bessere Skalierungseigenschaften und sind daher numerisch stabiler und effizienter. Betreuer: Maximilian Klein November 2016

Mai 2017

|

||||||

|

Bachelor thesis

Tim Ebbeke

Automatisierte Typ Spezialisierungen

Beschreibungstext anzeigen

Am Welfenlab wird gerade eine Datenflussbasiertes System (Buggy) entwickelt das unter anderem das Ziel verfolgt das manuelle Optimieren von Code zu automatisieren. Ein Teil dieses Problems ist die Optimierung der Datentypen, die in einem Programm verwendet werden. Z.B. sind Ganzzahloperationen schneller als Floating-Point Operationen. Oft wird deswegen der Datentyp int verwendet, auch wenn ein Floating-Point Typ genau die selben Ergebnisse liefern würde. Die Entscheidung welcher Typ wann am geeignetsten ist wird üblicherweise intuitiv vom Programmierer getroffen. In dieser Arbeit soll dieser intuitive Entscheidungsprozess analysieret werden und im existierenden Buggy-System algorithmisch eine automatisierte Typentscheidung implementiert werden die zunächst Datentypen wie double und int gegeneinander abwägt. Denkbar wären auch kompliziertere Typentscheidungen wie z.B. SIMD Typen oder ähnliches. Betreuer: Maximilian Klein November 2016

März 2017

|

||||||

| 2016 | ||||||

|

Master thesis

Falk-David Deppe

Institut für Mensch-Maschine-Kommunikation

Erkennung und Rekonstruktion von 3D Objekten aus RGBD-Daten

Beschreibungstext anzeigen

Durch die gestiegene Verfügbarkeit erschwinglicher RGBD-Sensoren hat das Gebiet der Virtual Reality in den letzten Jahren einen großen Aufschwung erlebt, da diese es erlauben, auch ohne spezialisierter Messgeräte virtuelle 3D-Modelle realer Szenen und Objekte zu erzeugen.

Betreuer: Andreas Tarnowsky April 2016

Oktober 2016

|

||||||

|

Bachelor thesis

Maik Marschner

Optimierung von Kontrollflussgraphen mit Graphersetzungssystemen

Beschreibungstext anzeigen

Die Optimierung von Programmen geschieht auf verschiedenen Abstraktionsebenen: Einerseits bei der Wahl des passenden Algorithmus, andererseits durch Transformationen des Programmquellcodes. Werden Transformationen angewandt so müssen diese ein äquivalentes Programm induzieren. Dies wird üblicherweise erreicht indem der Kontrollflussgraph des Programmes berechnet wird. In einem Kontrollflussgraphen sind alle Abhängigkeiten explizit gegeben wodurch äquivalente Programmtransformationen einfacher angegeben werden können. In den meisten Programmiersprachen wird dafür ein approximativer Kontrollflussgraph aus dem Programmquellcode berechnet.In dieser Arbeit wird ein Framework zum Erstellen und Anwenden von Graphersetzungssystemen erstellt, dass Programme die mit dem am Institut entwickelten System "Buggy" geschrieben sind, optimieren soll. Diese haben den Vorteil, dass der Kontrollflussgraph explizit und vollständig gegeben ist und überdies eine hierarchische Struktur vorhanden ist, die auch Optimierungen auf höheren Abstraktionsebenen ermöglichen können. Betreuer: Maximilian Klein April 2016

August 2016

|

||||||

|

Bachelor thesis

Jannik Bertram

Semantische Abstraktion von Programmiermodellen

Beschreibungstext anzeigen

In der Bachelorarbeit wird eine Prozedur ausgearbeitet, die Probleme, welche auf gegebenen Daten eines bestimmten Datentyps formuliert sind, verschiedene Lösungsfunktionen auswählen kann. Der Benutzer definiert im Idealfall lediglich das Problem und übergibt eine optionale Menge an Eigenschaften, die von der zu verwendenden Funktion erfüllt sein sollen. Das zugrunde liegende System soll dann mit Hilfe der drei Komponenten Eingabedaten, Problemstellung und den zu erfüllenden Eigenschaften eine Entscheidung treffen können, welcher Algorithmus für das Problem am sinnvollsten anzuwenden ist. Die Entscheidungsfindung wird dafür in eine statische Komponente (zur Erzeugung des Programmes) und eine dynamische Komponente (beim Ausführen des Programmes) unterteilt werden. Betreuer: Maximilian Klein April 2016

August 2016

|

||||||

|

Bachelor thesis

Thilo Schulz

Leibniz Universität Hannover

Entwurf und Implementierung eines Reeb Graph Analyse Moduls für die Segmentnachbearbeitung

Beschreibungstext anzeigen

In der modernen Medizin fallen heutzutage routinemäßig große Mengen an tomographischen Daten an. Neben der Datenhaltung an sich ist die Segmentierung, d.h. die Merkmalsextraktion, eines der wichtigsten Themen. Besonders für schwer zu klassifizierende traumatische Veränderungen (bspw. Trümerbruch) lassen sich in der Regel keine modellbasierte Verfahren verwenden. Hier muss auf allgemeine Verfahren zurückgegriffen werden, die in der richtigen Kombination eine gute Approximation der gewünschten Struktur liefern. Oft kommt es jedoch zu unerwünschten Übergängen, d.h. die eigentliche Struktur ist durch eine auflösungsbedingte Ungenauigkeit über eine (dünne) Verbindung mit weiteren Strukturen verbunden. Um diese zu identifizieren, haben sich das Konzept des Reeb Graph als nützlich erwiesen. Dabei wird schichtweise nach Zusammenhangskomponenten gesucht und diese mit ihren Verbindungen zu Komponenten in den benachbarten Schichten in einer Graph Struktur abgelegt. Betreuer: kif@gdv.uni-hannover.de Januar 2016

Mai 2016

|

||||||

|

Bachelor thesis

Yannic Rath

Verlässliches Quad-Remeshing

Beschreibungstext anzeigen

Insbesondere durch ihre vielseitige Verwendbarkeit kommen Vierecksgittern eine zunehmend größere Bedeutung zu. Die Visualisierung von 3D-Objekten mithilfe von Vierecken ist zum einen optisch deutlich ansprechender als die Darstellung mit „herkömmlichen“ Dreiecksgittern und zum anderen bieten sie meist eine bessere Grundlage für weiterführende Anwendungen wie z. B. Texturierung. Nichtsdestotrotz ist die Berechnung dieser Gitter durchaus kompliziert. Während Dreiecksgitter einfach durch Algorithmen wie die Delaunay-Triangulation erzeugt werden können, sind die meisten aktuellen Algorithmen für Vierecksgitter, insbesondere in Bezug auf Effizienz und Verlässlichkeit, verhältnismäßig eingeschränkt. Unser Hauptziel ist es daher einen neuen Quad-Remeshing-Algorithmus zu implementieren, welcher aus einem gegebenen Dreiecksnetz ein Vierecksgitter erzeugt. Um dies zu erreichen werden wir einen Parametrisierungs-Ansatz verwenden, d. h. das kartesische Netzgitter soll mithilfe einer globalen Parametrisierung auf die Oberfläche projiziert werden. Dies lässt sich auf ein gemischt-ganzzahliges Optimierungsproblem zurückführen, welches effektiv und zuverlässig durch Anwendung verschiedener Komplexitätsreduktionen und Ausnutzen weiterer Zwangsbedingungen gelöst werden kann. Wir werden diese auf aktuellen Publikationen basierende Methode im Hinblick auf Verlässlichkeit und Effizienz untersuchen, um ihre Stärken und Schwächen herauszustellen. Hiermit werden wir versuchen weitere Optimierungen zu entwickeln, um einen allgemeineren Quad-Remeshing Algorithmus zu erstellen, welcher „echte“ Vierecksgitter effizient und verlässlich erzeugt. Betreuer: Daniel Brandes Dezember 2015

April 2016

|

||||||

|

Bachelor thesis

Frederik Nörmann

Interaktive Code Abstraktionen

Beschreibungstext anzeigen

Beim Schreiben von Code entstehen häufig Situationen in denen die verwendete Programmiersprache nicht optimal geeignet ist um den jeweiligen Sachverhalt darzustellen. Insbesondere graphische Repräsentationen des zugrundeliegenden Problems könnten beim Lesen des Codes oft hilfreich sein. Modernere Entwicklungsumgebungen sind so vielseitig, dass das Einbinden von graphischen Elementen kein Problem wäre. Dennoch gibt es nicht einmal die Möglichkeit in Kommentaren graphische Elemente einbinden zu können. Interaktive Elemente sind noch weniger verbreitet.Diese Arbeit beschäftigt sich mit der Entwicklung eines Editor-Plugins (für Atom), welches es zunächst ermöglichen soll graphische Elemente in Editoren einbinden zu können. Darauf aufbauend soll eine Abstraktion von gewissen Code Elementen durch grafische Bausteine ermöglicht werden. Z.B. Bezier Splines über entsprechende graphischen Interfaces eingegeben. Betreuer: Maximilian Klein November 2015

März 2016

|

||||||

| 2015 | ||||||

|

Bachelor thesis

Lorenz Dames

Leibniz Universität Hannover

Codegenerierung für symbolische Mathematik

Beschreibungstext anzeigen

Probleme in der Differentialgeometrie oder Finiten Elemente Methode erfordern häufig die Umsetzung komplexer mathematischer Zusammenhänge in einer mehr oder weniger dafür geeigneten Programmiersprache. Häufige Anwendungen sind unter anderem die automatische Bestimmung von Ableitungen, numerische Integration und die Aufstellung symbolischer Matrizen. Betreuer: Rasmus Buchmann Mai 2015

September 2015

|

||||||

|

Bachelor thesis

Sebastian Veitleder

Thin Shell Simulation der Basilarmembran

Beschreibungstext anzeigen

This work is researching the response of the basilar membrane of the human cochlear to different stimuli from the scala tympani. A triangle mesh of the basilar membrane is used to produce a shell model. On this model a three-dimensional thin shell simulation is performed by using a modified cloth simulator that accounts for flexural energy over the mesh edges. The force that the scala tympani would induce on the basilar membrane is directly applied to the simulated model. A Lattice-Boltzman fluid simulation generates reasonable forces to apply to the model and observe. Several examples show the validity of the simulation. Betreuer: Maximilian Klein Mai 2015

September 2015

|

||||||

|

Bachelor thesis

Hermann Kroll

Leibniz Universität Hannover

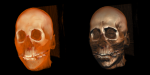

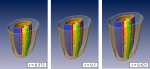

Erkennung der Substrukturen des Acetabulum in 3D-Pelvis Modellen

Beschreibungstext anzeigen

Für die Planung von Hüftoperationen ist eine genaue Analyse der patientenindividuellen Geometrie erforderlich. Dabei ist vor allem die Oberflächenstruktur der Hüftpfanne (Acetabulum) als Kontaktregion zum Femurkopf von besonderem Interesse. Betreuer: Karl-Ingo Friese Mai 2015

September 2015

|

||||||

|

Bachelor thesis

Jakob Riga

Leibniz Universität Hannover

Entwurf und Entwicklung einer haptischen Eingabemethode zur Erfassen von Metainformationen auf 3D-Oberflächen

Beschreibungstext anzeigen

In klinischen Prozessen spielt die tomographische Bildgewinnung heutzutage eine immer größere Rolle. Die dabei gewonnen Schichtbilddaten sind jedoch nur der erste Schritt eines komplexen Verarbeitungsprozesses. Eine auch heute noch schwierige Aufgabe ist die sogenannte Segmentierung, bei der bestimmte Substrukturen (Organe, Knochen, ...) identifiziert werden. Als besonders vielversprechend haben sich dabei Algorithmen gezeigt, die anwendungsspezifisches Modellwissen mit einbeziehen (modelbasierte Segmentierung). Betreuer: Karl-Ingo Friese Juli 2015

September 2015

|

||||||

|

Bachelor thesis

Stephan Singer

Leibniz Universität Hannover

Vergleich von SIFT und einer neuen HKS-Methode zur Bildanalyse

Beschreibungstext anzeigen

Um Bilder auf Ähnlichkeit zu vergleichen, kann man aus den Umgebungen ausgewählter Punkte Featuredeskriptoren extrahieren und anschließend diese vergleichen. Ein etabliertes Verfahren dazu ist SIFT (Scale invariant feature transform). Zum Vergleich von 3D-Formen gibt es als Featuredeskriptoren di sogenannten Heat Kernel Signatures, die die geometrische Umgebung eines Punktes dadurch beschreiben, wie er abkühlen würde, wenn man ihn erhitzt. Mittels am Welfenlab entwickelter bildabhängig modifizierter Laplaceoperatoren kann ein Analogen der Wärmeleitungsgleichung auch für Bilddaten aufgestellt und so eine HKS für Punkte in Bildern definiert werden. In der Bachelorarbeit werden SIFT und HKS für Bilder miteinander verglichen. Betreuer: Benjamin Berger Juni 2015

September 2015

|

||||||

|

Bachelor thesis

Alexander Treptau

Cochleasimulation mit dem Lattice Boltzmann Verfahren

Beschreibungstext anzeigen

Die Cochlea ist der Teil des Innenohrs, der für die Aufnahme der auditiven Reize zuständig ist. Dabei breitet sich eine Schallwelle in einem Fluid aus und versetzt die Membran des Corti-Organs in Bewegung, sodass diese die mechanischen Schwingungen in Nervenimpulse umwandeln kann. Bei dem Lattice Boltzmann Verfahren wird ein Fluid mithilfe eines zellulären Automaten auf Teilchenebene diskretisiert. Unter Verwendung dieses Verfahrens kombiniert mit der Immersed Boundary Methode wird die Mechanik einer zweidimensionalen Cochlea modelliert und analysiert. Dabei soll insbesondere die Lokalisierung der eingehenden Schallwellen durch das ovale Fenster auf der Basilarmembran nachgebildet werden und mit den Ergebnissen von u.a. Gerstenberger et al 2013 verglichen werden. Betreuer: Maximilian Klein April 2015

August 2015

|

||||||

|

Master thesis

Daniel Busse

Leibniz Universität Hannover

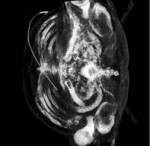

Entwicklung eines stochastischen Modells für die 3D-Segmentierung medizinischer Tomographiedaten

Beschreibungstext anzeigen

Die Medizin hat im letzten Jahrhundert in Form von bildgebenden Verfahren ein bedeutendes Hilfsmittel erhalten. Basierend auf verschiedenen physikalischen Eigenschaften, bilden sie die innere Anatomie eines Patienten auf diskrete Volumendaten ab: Es entstehen dreidimensionale Bilder, auf denen unterschiedliche Gewebearten durch variierende Grauwerte dargestellt werden. Betreuer: Karl-Ingo Friese Januar 2015

Juli 2015

|

||||||

|

Bachelor thesis

Thomas Winter

Die Immersed Boundary Methode für das Lattice Boltzmann Verfahren

Beschreibungstext anzeigen

In dieser Arbeit wird das Zusammenspiel der Lattice Boltzmann Methode mit dem Immersed Boundary Verfahren untersucht. Das Lattice Boltzmann Verfahren ist ein gribbasierter Fluid Löser der mit relativ einfachen lokalen Regeln die Boltzmanngleichung lösen kann. Um nun komplexe Geometrien die nicht am Gitter ausgerichtete sind zu unterstüzen soll das Immersed Boundary Verfahren verwendet werden. Dieses ermöglicht es Obejkte die physikalisch nicht auf dem Gitter simuliert werden mit dem Fluid zu koppeln. So können die Vorteile der Lattice Boltzmann Methode ausgenutzt werden (z.B. die hervoragende Parallelisierbarkeit) ohne dabei auf Modelle in Lagranger Sicht verzichten zu müssen. In dieser Arbeit wird dafür eine stabile Kopplung verschiedener Systeme mit dem Immersed Boundary Verfahren vorgestellt und soweit möglich mit Literaturwerten verglichen. Betreuer: Maximilian Klein November 2014

März 2015

|

||||||

|

Bachelor thesis

Ferdinand Lange

Visualisierung von 3D Fluiden

Beschreibungstext anzeigen

Bei der Visualisierung von Fluiden in drei Dimensionen müssen viele Daten in verständlicher Form dargestellt werden. Da die große Menge an verschiedenen Daten in einer Grafik meist kompliziert und nicht unbedingt verständlich ist, beschäftigt sich diese Arbeit mit Möglichkeiten Fluide in drei Dimensionen anschaulich zu visualisieren. Um Fluide zu Visualisieren müssen grundsätzlich zwei Arten von Felder dargestellt werden können. Einmal skalare Felder wie z.B. der Druck oder die Dichte, andererseits Vektor Felder wie die Geschwindigkeit. Problematisch ist dabei oft die Überdeckung von Details die inmitten des beobachteten Volumens liegen. Dafür soll diese Bachelorarbeit Möglichkeiten schaffen Felder darzustellen und geeignet filtern zu können um spezifierte Regionen einzublenden und andere auszublenden. Betreuer: Maximilian Klein November 2014

März 2015

|

||||||

|

Bachelor thesis

Sven Gesper

Mensch-Maschine-Kommunikation

Untersuchungen zur Parallelisierbarkeit von auf stochastischen Suchverfahren basierenden asynchronen variationellen Integratoren

Beschreibungstext anzeigen

In dem Projekt "Tactil Displays for Virtual Reality Applications" wird mittels einer FEM-Simulation, die sich auf Asynchrone Variationelle Integration (AVI) stützt, der Kontakt eines Fingers mit einer Oberfläche simuliert. Da jedes Element in einem individuellen Zeitschritt berechnet wird, muss ein Algorithmus darüber wachen, dass die gesamte Simulation zeitlich möglichst kontinuierlich abläuft und keine zu großen Abstände zwischen den Elementen herrschen. Eine hohe Geschwindigkeit kann durch Parallelisierung der Simulation erreicht werden. Die Reihenfolge der Berechnung der AVI-Elemente wird durch einen Algorithmus ermittelt, der hinsichtlich seiner Parallelisierbarkeit durch unterschiedliche Kollisionsbehandlungen untersucht wird. Die Anzahl der Kollisionen sowie der gleichmäßig Fortschritt in der Zeit sind zu optimierende Aspekte. Betreuer: Daniel Brandes September 2014

Januar 2015

|

||||||

| 2014 | ||||||

|

Bachelor thesis

Felix Schliephacke

Gebietszerlegung für die Lattice Boltzmann Methode auf verteilten Speicherarchitekturen

Beschreibungstext anzeigen

Das Lattice Boltzmann Verfahren ist ein Verfahren das die Boltzmanngleichung lösen kann, welches auf einem regulären Gitter mittels einfacher Evolutionsregeln, ähnlich derer eines Zellulären Automatens, arbeitet. Bei der Implementierung einer verteilten Simulation sind insbesondere die Latenzen ein den Speedup begrezender Faktor. Die Latenzen entstehen dabei hauptsächlich durch den Abgleich der Randbereiche. Deswegen versucht man beim Erstellen der einzelnen Subdomains die Randbereiche so klein wie möglich zu halten, dabei soll jedoch das Innere so groß wie möglich bleiben. Ziel dieser Arbeit ist es eine möglichst optimale Zerlegung einer Domäne in Teilbereiche zu finden. Dazu sind insbesondere die Rechengeschwindigkeit der einzelnen Rechner und die Geschwindigkeit der einzelnen Netzwerkverbindungen zu beachten. Betreuer: Maximilian Klein Mai 2014

Oktober 2014

|

||||||

|

Bachelor thesis

Jan Jamaszyk

Leibniz Universität Hannover

Übertragungsfunktion für die Mechanik der Fingerspitze

Beschreibungstext anzeigen

Eine Wahrnehmung der „virtuellen Welt“ beschränkt sich aktuell größtenteils auf den optischen, sowie den akustischen Sinn. Um realistische Sinneseindrücke zu vermitteln wäre eine Verwendung des taktilen Sinnes wünschenswert. Im Rahmen dieser Arbeit soll eine Übertragungsfunktion entwickelt werden, die den Zusammenhang zwischen mechanischer Kraft des Aktuators und entsprechenden Stressmaßen am Rezeptor, basierend auf den Daten einer Finite-Elemente Simulation, beschreibt. Mittels Inversion dieser Funktion sollen so später optimale Anregungen der Aktuatoren gefunden werden, die den Eindruck realer Oberflächen möglichst detailgetreu abbilden. Betreuer: Rasmus Buchmann, Alexander Vais Betreuer: Rasmus Buchmann Juni 2014

Oktober 2014

|

||||||

|

Bachelor thesis

Nils Hein

Leibniz Universität Hannover

Strukturerhaltende Fluidsimulation

Beschreibungstext anzeigen

Visuelle Qualität und kurze Berechnungszeiten sind wichtige Eigenschaften einer Fluidsimulation, die erreicht werden müssen ohne die Stabilität der Simulation zu beeinträchtigen. Häufig verwendete Methoden wie "Stable Fluids" oder "Smoothed Particle Hydrodynamics" sind nicht ausreichend um die Vortizität eines Fluids ausreichend abzubilden. Diese Arbeit implementiert daher ein auf dem sog. "Discrete Exterior Calculus" basierendes Framework, dass die physikalischen Größen als diskrete Differentialformen modelliert und die zeitliche Entwicklung des Fluids über einen geometrisch motivierten Integrationsalgorithmus berechnet. Betreuer: Rasmus Buchmann Juni 2014

Oktober 2014

|

||||||

|

Bachelor thesis

Falk-David Deppe

Institut für Mensch-Maschine-Kommunikation

Zeitadaptive asynchrone Textilsimulation

Beschreibungstext anzeigen

In dieser Arbeit soll eine Textilsimulation mit einem einfachen Kontaktmodell implementiert werden, die sich an der haptischen Textilsimulation des HAPTEX Projektes orientiert. Einer der wesentlichen Anforderungen an die Simulation ist daher eine hohe Simulationsgeschwindigkeit, um die für haptisches Empfinden benötigten 1000Hz im Kontaktbereich erreichen zu können. Im Gegensatz zu dem vorangegangenem HAPTEX-Projekt soll ein FEM basierender Algorithmus implementiert werden, der sich auf die sog. Asynchrone Variationelle Integration (AVI) stützt. Dieser Ansatz hat den Vorteil, jedes Element mit einen individuellen Zeitschritt berechnen zu können. In dieser Arbeit soll nun untersucht werden, inwiefern es möglich ist, mit einem zeitadaptiven Ansatz die o.g. Anforderungen an die haptische Echtzeit zu erfüllen. Betreuer: Andreas Tarnowsky Mai 2014

Oktober 2014

|

||||||

|

Bachelor thesis

Sven Feldkord

Institut für Mensch-Maschine-Kommunikation

A scalable controller for operating multidirectional tactile arrays

Beschreibungstext anzeigen

In dem durch die DFG geförderten Projekt "Tactile Displays for Virtual-Reality-Applications" wird in Kooperation mit dem Institut für Dynamik und Schwingungen (IDS) und dem Institut für Mikroproduktionstechnik (IMPT) ein sog. taktiles Display entwickelt, welches in der Lage ist, den Wahrnehmungseindruck real existierender Oberflächen auf einem Array von beweglichen Stiften nachzubilden. Am Institut für Mensch-Maschine-Kommunikation wird zur Zeit ein Modell entwickelt, welches die für die Erzeugung dieses taktilen Eindrucks notwendigen Parameter in Form von zeitlich variablen diskreten Frequenzspektren auf Basis gegebener Oberflächenparameter bestimmt. Ziel dieser Arbeit ist es, eine Hardwareeinheit zu konzipieren und zu realisieren, welche die durch das Modell gegebenen diskreten Frequenzspektren in ein kontinuierliches Signal umsetzt, welches zur Ansteuerung des taktilen Displays verwendet werden kann. Wesentliche Anforderungen an dieser Hardwareeinheit sind neben einer hohe Qualität des Ausgangssignals auch eine einfache Möglichkeit der Skalierung auf größere Displays. Betreuer: Andreas Tarnowsky Mai 2014

Oktober 2014

|

||||||

|

Bachelor thesis

Jurek Leonhardt

Automatische Erkennung des Acetabulum in 3D-Pelvis Modellen

Beschreibungstext anzeigen

Hüftimplantate zählen zu den häufigsten orthopädischen Operationen. Für eine patientenindividuelle Planung von Implantat und Eingriff ist es notwendig, sowohl die Hüfte (Pelvis) als auch den Oberschenkelknochen (Femur) zu identifizieren. Von besonderem Interesse ist dabei die Kontaktregion, die aus dem Kopf des Femur (caput ossis femoris) und der Hüftpfanne (acetabulum) besteht.

Ziel dieser Arbeit ist es, das Acetabulum in gegebenen 3D-Pelvis Modellen zu identifizieren. Dafür sollen unterschiedliche Algorithmen untersucht, implementiert und verglichen werden. Betreuer: Karl-Ingo Friese Mai 2014

September 2014

|

||||||

|

Bachelor thesis

Thilo Schnelle

Fluidsimulation mit dem Lattice Boltzmann Verfahren

Beschreibungstext anzeigen

In dieser Arbeit soll eine Fluidsimulation mit der Lattice Boltzmann Methode implementiert werden. Diese Methode diskretisiert das Fluid mit zellulären Automaten und erreicht dadurch eine hohe Parallelität. Teil dieser Arbeit ist die Beschreibung der Diskretisierung, die im Lattice Boltzmann Verfahren angewandt wird. Zusätzlich dazu soll das Verfahren implementiert werden und anhand üblicher Beispiele wie dem "Lid-Driven-Cavity-Flow" Beispiel mit bekannten Lösungsverfahren verglichen werden. Dabei sind insbesondere die Konvergenzraten, Parallelität, Einhaltung der Inkompressibilitätsbedingung und die Interaktion mit Objekten von Interesse. Betreuer: Maximilian Klein Mai 2014

September 2014

|

||||||

|

Bachelor thesis

Wolff Bock von Wülfingen

Das Lattice Boltzmann Verfahren für Cluster Architekturen

Beschreibungstext anzeigen

Diese Arbeit befasst sich mit der Parallelisierung des Lattice Boltzmann Verfahrens. Das Lattice Boltzmann Verfahren löst die Boltzmanngleichung über eine reguläre Diskretisierung und verwendet Regeln ähnlich der von Zellulären Automaten. Diese Formulierung hat den großen Vorteil, dass sie lokal arbeitet und somit leicht parallelisierbar ist. In dieser Arbeit wird neben der Shared-Memory Parallelisierung auch die Parallelisierung auf ein Clustersystem untersucht. Dazu wird ein Protokoll zur Kommunikations der einzelnen Rechner entwickelt welches möglichst gut Latenzen überdecken soll. Betreuer: Maximilian Klein April 2014

August 2014

|

||||||

|

Bachelor thesis

Adrian Hengelhaupt

Mensch-Maschine-Kommunikation

Adaptive 3D-Visualization of fractal Heightmaps using Tessellation Shaders

Beschreibungstext anzeigen

Das Institut für Mensch-Maschine-Kommunikation verfügt über vielfältige Visualisierungs- und Interaktionssysteme für Virtual-Reality Applikationen. Als Demonstrationsanwendung soll eine Interaktive 3D-Umgebung geschaffen werden, die fortgeschrittene 3D-Visualisierung, haptische Interaktion und physikalische Simulation beinhaltet.

Ziel dieser Arbeit ist es, existierende Algorithmen zur Generierung von fraktalen Höhenkarten einzusetzen, um virtuell erkundbare Landschaften in Echtzeit dreidimensional visualisieren zu können. Um eine jederzeit flüssige und zugleich qualitativ hochwertige Darstellung zu garantieren, soll eine adaptive Verfeinerung eines Basismeshes durch einen Tessellation-Shader realisiert werden. Als Kriterium für die Verfeinerung können beispielsweise Gradienteninformationen der Höhenkarte ausgewertet werden.

Die Programmierung erfolgt in C++ und OpenGL. Als Basis für die Implementierung dient das aus dem Labor "Grafikprogrammierung" bekannte auf Qt basierende GDV-Framework. Betreuer: Andreas Tarnowsky November 2013

März 2014

|

||||||

| 2013 | ||||||

|

Diploma thesis

Dennis Schridde

Mensch-Maschine-Kommunikation

Geometrische Integrationsmethoden für Kontinuumsmechanik

Beschreibungstext anzeigen

Diese Arbeit präsentiert ein Verfahren zur Lösung von physikalisch motivierten partiellen Differentialgleichungen. Es wird erklärt, wie mit Hilfe der Hamiltonschen Formulierung aus den beschreibenden Gleichungen des physikalischen Systems ein zeit- und raumdiskreter Integrationsalgorithmus hergeleitet werden kann und wie hierbei durch Beachtung bestimmter Raum-Zeit Symmetrien die für physikalische Simulationen so wichtige Energie- und Momenterhaltung umgesetzt wird. Außerdem wird dargestellt, wie es möglich ist, Teilsysteme in jeweils unterschiedlichen Zeitschritten zu berechnen. Zusätzlich zur rein theoretischen Erläuterung des Verfahrens und seiner physikalischen und mathematischen Grundlagen wird eine Implementation desselben vorgestellt und an ausgewählten Beispielen untersucht. Betreuer: Rasmus Buchmann Mai 2013

November 2013

|

||||||

|

Bachelor thesis

Markus Schulze

Haptisches Heightfieldwater

Beschreibungstext anzeigen

Diese Arbeit befasst sich mit einem einfachen Wassermodell, das in der einfachsten Form nur aus Höhendaten besteht. Die Simulation eines solchen Wassers erweist sich als äußerst effizient, jedoch können einige Eigenschaften des Wassers nicht abgebildet werden. Für dieses sogenannte Heightfieldwater gibt es zahlreiche Publikationen über das Zusammenspiel mit starren Körpern. Diese erlauben es die Kräfte auf die Objekte realistisch zu berechnen.

Zusätzlich existieren am Institut haptische Eingabegeräte die es erlauben Kräfte auszugeben. Für eine natürliche Interaktion sind dafür hohe Wiederholraten (am besten 1000Hz) erfordertlich. Dies lässt sich nur über eine gescheite Wahl der Modelle realisieren. Im Bereich der Wassersimulation gilt das Heightfieldwater als am wenigsten aufwändig und ist deswegen ein interessanter Kandidat für eine haptische Interaktion.

In dieser Arbeit soll primär die Interaktion mit dem Wasser implementiert werden. Für die Interaktion der Körper untereinander soll Bullet verwendet werden.

Beschreibungstext verbergen

Betreuer: Maximilian Klein Mai 2013

September 2013

|

||||||

|

Bachelor thesis

Volker Schmidt

Über den Einfluss von Kompressionen auf das paralle superkonvergente Multigrid Verfahren

Beschreibungstext anzeigen

Das Multigrid Verfahren ist eines der performantesten Verfahren zum Lösen von Linearen Gleichungssystemen. Insbesondere für physikalische Probleme hat sich das das Multigrid Verfahren bewährt [1].

Für das Multigrid Verfahren existieren einige Parallelisierungsmöglichkeiten. Der Großteil setzt dabei jedoch an den Lösern für die linearen Gleichungssysteme an, die auch Smoother genannt werden. Ein ganz anderen Ansatz verfolgt das PSMG (parallele superkonvergente Multigrid) Verfahren [2]. Das Multigrid Verfahren versucht die Lösung im feinen Grid durch eine grobe Approximation des Fehlers auszugleichen und damit die Konvergenz zu beschleunigen. Für das Erstellen des groben Problems gibt es mehrere Möglichkeiten von denen üblicherweise eine gewählt wird. Im PSMG werden dahingegen alle Möglichkeiten gewählt und all diese werden parallel gelöst. Das PSMG Verfahren besitzt eine deutlich höhere Konvergenzrate als herkömmliche Verfahren jedoch erfordert sie auch einen größeren Kommunikationsoverhead.

Ziel dieser Arbeit soll es sein, den Poisson Solver einer Fluid Simulation, zum Berechnen des Druckausgleiches, mittels PSMG zu realisieren. Dabei soll untersucht werden, ob Kompressionsalgorithmen den Kommunikationsaufwand signifikant zu verringern können.

Beschreibungstext verbergen

Betreuer: Maximilian Klein Juni 2013

August 2013

|

||||||

|

Master thesis

Friedrich Hattendorf

Implementation und Analyse von Triangle Strip Algorithmen

Beschreibungstext anzeigen

Volumenkörper werden in der Computergrafik oft durch die Darstellung ihrer Oberfläche als Dreiecksnetz repräsentiert. Gerade bei komplexeren Objekten kann dabei die Dreieckszahl schnell mehrere Millionen erreichen, was auch heute noch eine Herausforderung für die Grafikkarte darstellt. Zwar existieren Verfahren, die ein Dreiecksnetz vereinfachen (= die Anzahl der Dreiekce reduzieren), dabei besteht jedoch immer die Gefahr, dass wichtige Details der Oberfläche Verloren gehen können oder schlimmstenfalls sogar Selbstüberschneidungen erzeugt werden. Eine interessante Alternative stellen die sogenannten Triangle-Strips dar. Bei dieser Datenstruktur, wird versucht, das Netz aus möglichst langen Dreiecks-Streifen zusammenzusetzen, bei der sich jeweilst zwei aufeinanderfolgende Dreiecke genau eine Kante teilen. Durch diesen Trick lässt sich im Idealfall der benöitgte Speicheraufwand auf 1/3 reduzieren. Das Problem der Findung einer solchen idealen Zerlegung ist jedoch N(P) vollständig. Daher existieren eine Vielzahl von Verfahren, die mit heuristischen Methoden versuchen, eine möglichst gute Triangle Strip Darstellung zu finden. Ziel dieser Arbeit ist es, verschiedene Verfahren aus dieser Kateogrie zu implementieren und für Dreiecksflächen aus medizinischen Anwendungen zu vergleichen. Zusätzlich soll ein eigenes Verfahren implentiert werden, bei dem der Augenmerk nicht in einer möglichst guten Strip Darstellung sondern der Erzeugung der Strip Struktur ohne nennenswerten Zeit- und Speicheraufwand liegt. Betreuer: Karl-Ingo Friese November 2012

Mai 2013

|

||||||

|

Bachelor thesis

Roman Zimbelmann

Haptisches Modellieren

Beschreibungstext anzeigen

In dieser Arbeit soll ein haptisches Gerät (z.B. das Phantom) verwendet werden um ein haptische Virtual Clay Simulation zu entwickeln. Das haptische Gerät soll einem dabei die Möglichkeit geben ein virtuelles Objekt zu verformen und vielleicht auch topologisch zu ändern, um so verschiedenste Modelle fertigen zu können. Dazu sollen verschiedene Werkzeuge angeboten werden, die einem das Modellieren erleichtern sollen. Es soll zunächst recherchiert werden ob Mesh-based, Voxel-based oder gemischte Verfahren am besten geeignet für die haptische Interaktionen sind . Die große Herausforderung steckt dabei im Erreichen der haptischen Echtzeit, die 1000 fps benötigt. Technisch kann dieses über lokal-adaptive Verfahren erreicht werden. Ein Teil dieser Arbeit wird sein, die vorhandene Netzwerkschnittstelle für die haptischen Geräte zu vervollständigen. Eine Bachelorarbeit / Studienarbeit mit geringerem Umfang ist auch denkbar. Betreuer: Maximilian Klein November 2012

März 2013

|

||||||

|

Bachelor thesis

Sven Röttering

Vegetationsgenerierung mittels Zellulärer Automaten und Spieltheorie

Beschreibungstext anzeigen

Der am Institut entwickelte prozedurale Planetengenerator kann Terrain-Daten für einen Planeten mit verschiedenen klimatischen Zonen aus einem einzelnem Seed erzeugen. Der daraus resultierende Planet verfügt jedoch noch über keine Vegetation. Ein manuelles setzen der Vegetation ist nicht nur aufwändig, sondern führt auch zu unrealistische wirkenden Regionen. Deshalb soll in dieser Arbeit ein System entworfen werden, welches eine Vegetation für einen zufällig generierten Planeten erzeugt und auch visualisiert. Technisch soll die Vegetation durch einen Zellulären Automaten unter Zuhilfenahme von spieltheoretischen Modellen erzeugt werden. Dazu muss ein Basisdatensatz an Vegetationsobjekten wie Bäumen, Kakteen, Sträuchern, etc. erzeugt werden und geeignet kategorisiert werden. Unter Zuhilfenahme dieses Datensatzes soll auf der Oberfläche ein Zellulärer Automat simuliert werden, dessen Regeln sich aus dem spieltheoretischen Modell und den klimatischen Gegebenheiten ableiten. Betreuer: Maximilian Klein Oktober 2012

Februar 2013

|

||||||

|

Seminarpaper

Volker Schmidt

Real Time Forest Rendering

Beschreibungstext anzeigen

Visualizing a huge amount of complex models can be a time consuming part of the rendering process. For many complex objects specialized methods exist. This seminartopic is about the realtime visualization of forests.

Rendering forests can be a time consuimg task making it hard to find a method that is capable of rendering many trees in real time while maintining a decent visual quality. To achieve interactive framerates many methods introduce simplifications that lead to so called popping artifacts that distract the user and lower the immersion.

In recent years many advances and the development of modern graphics hardware lead to more elaborated methods which are capable of processing and rendering millions of trees in real time and with popping artifacts and convincing lighting effects. Betreuer: Maximilian Klein Oktober 2012

Januar 2013

|

||||||

| 2012 | ||||||

|

Master thesis

Marco Köhnen

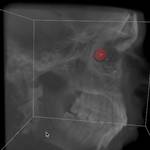

Entwicklung einer halbautomatischen Segmentierungsmethode zur Bestimmung der intrakraniellen Luftmenge nach einer Schädeloperation

Beschreibungstext anzeigen

In dieser Arbeit soll ein neuer Ansatz automatischer Verfahren mit Hilfe von Deformable Models und gängiger Segmentierungsverfahren verfolgt werden, um den Liquorverlust nach einer Schädel-Operation zu Bestimmen.

Beschreibungstext verbergen

Hintergrund sind Operationen, bei denen der Patient in einer halb-sitzenden Stellung am Hinterkopf operiert wird. Eine Folge davon ist ein Verlust an Flüssigkeit, die sich im Laufe der Zeit rückbildet. Um diesen Rückbildungsprozess untersuchen zu können, soll ein halb-automatisches Verfahren zur Bestimmung der intrakraniellen Luftmenge etnwickelt und mittels umfangreicher bereits vorliegender Daten auf Reproduzierbarkeit und Güte getestet werden.

Hintergrund sind Operationen, bei denen der Patient in einer halb-sitzenden Stellung am Hinterkopf operiert wird. Eine Folge davon ist ein Verlust an Flüssigkeit, die sich im Laufe der Zeit rückbildet. Um diesen Rückbildungsprozess untersuchen zu können, soll ein halb-automatisches Verfahren zur Bestimmung der intrakraniellen Luftmenge etnwickelt und mittels umfangreicher bereits vorliegender Daten auf Reproduzierbarkeit und Güte getestet werden.

Betreuer: Karl-Ingo Friese Juni 2012

Dezember 2012

|

||||||

|

Diploma thesis

Daniel Brandes

Leibniz Universität Hannover

Finite Elemente Berechnung zur Spektralen Zerlegung von Laplace Operatoren auf Linienbündeln über dreidimensionalen Objekten.

April 2012

Oktober 2012

|

||||||

|

Bachelor thesis

Peter Denis

Stereographische Visualisierung von 360° Aufnahmen auf einem Head Mounted Display (HMD)

Beschreibungstext anzeigen

Seit einiger Zeit sind Panoramafotos ein beliebtes Mittel zur Illustration von öffentlichen Plätzen oder Produkten geworden. Klassischerweise wird dabei eine normale Kamera rotiert und die dabei entstehenden Einzelaufnahmen zu einem großen Panorama zusammengefügt. Projiziert man dieses Panorambild zusätzlich auf eine zylindrische Geometrie, entsteht der Eindruck, als ob man sich in der Szene befindet.

Beschreibungstext verbergen

Betreuer: Karl-Ingo Friese Mai 2012

September 2012

|

||||||

|

Bachelor thesis

Marc Lühr

Interaktive Szeneexploration mittels Datenhandschuh und optischem Tracking

Beschreibungstext anzeigen

Im alltäglichen Leben ist die Hand einer der wesentlichsten Werkzeuge um mit der umgebenden Welt zu interagieren. Diese Interaktionsmöglichkeit wird bei der Arbeit mit Computern nur unzureichend über eingaben via Tastatur und Maus umgesetzt. Besonders bei Interaktionen mit einer dreidimensionalen Welt sind diese limitierten Werkzeuge ein großes Hinderniss für eine intuitive Steuerung. Natürlicher wäre eine Steuerung die die Bewegung der Hände mit einbeziehen würde. Dazu soll in dieser Bachelorarbeit der CyberGlove 2 Datenhandschuh zur Exploration einer dreidimensionalen Szene verwendet werden. Die Fingerstellung wird dabei über Widerstandssensoren im Handschuh gemessen und kann so zur Darstellung des Handmodells verwendet werden. Die Informationen über die Lage der Hand im Raum soll anschließend, durch am Kopf befestigte Kameras und Marker auf der Hand, rekonstruiert werden. Diese Arbeit soll in ein plattformunabhängiges Java-Framework integriert werden, dass die Darstellung dreidimensionaler Szenen mittels eines Head-Mounted-Displays ermöglicht soll. Die Darstellung wird in der Bachelorarbiet "Stereographische Visualisierung von 360° Aufnahmen auf einem Head Mounted Display (HMD)" durch Peter Denis implementiert. Durch die stereoskopsiche Darstellung der Szene gepaart mit der Interaktion durch die Hand soll so eine hohe Immersion erreicht werden, die ein intuitives Arbeiten in der virtuellen Szene erlaubt. Betreuer: Karl-Ingo Friese Mai 2012

September 2012

|

||||||

|

Bachelor thesis

Oliver Weidner

Implementation eines Echtzeitmodells für den Wasserkreislauf

Beschreibungstext anzeigen

Auf Basis der vorangegangen Bachelorarbeit "Prozedurale Multiskalen-Generierung von Planetenoberflächen" angefertigt von Felix Haase, soll in dieser Arbeit ein physikalisches Modell entwickelt werden, dass den Wasserkreislauf eines Planeten simuliert. Das Modell für den Wasserkreislauf arbeitet mit verschiedenen Schichten, die z.B. die Planetenoberfläche und die Atmosphäre darstellen. In diesen Schichten werden unterschiedliche Modelle simuliert, so soll für die Atmosphäre ein projiziertes SPH Fluid verwendet werden. Ziel dieser Arbeit ist die Implementierung einer interaktiven Simulation auf einer Planetenoberfläche, die neben einer plausiblen Wolkenmechanik in der Atmosphäre auch eine realistisch wirkende Entwicklung der Vegetation auf der Planetenoberfläche ermöglichen soll. Betreuer: Maximilian Klein Mai 2012

September 2012

|

||||||

|

Bachelor thesis

Artem Leichter

Leibniz Universität Hannover, DLR Braunschweig

Generierung von 4D Ausweichtrajektorien

Beschreibungstext anzeigen

Bei den aktuellen Planungsverfahren für den Luftverkehr entstehen regelmäßig Situationen, in denen die Flugzeuge die gesetzlich vorgeschriebenen Sicherheitsabstände nicht einhalten können. Diese Unterschreitungen werden als Kollisionen bezeichnet. Es gibt verschiedene Verfahren zur Erkennung von Kollisionen und zur Aulösung von Kollisionssituationen. Diese Verfahren sind wenig integriert und nutzen nicht die Vorteile der modernen Navigationstechnologie (z.B. DG-PS). Die Ausweichtrajektorien werden nicht optimiert. Am DLR (Deutsches Zentrum für Luft- und Raumfahrt) werden die Trajektorien als Teil des 4D-Raumes abgebildet. Der 4D-Raum setzt sich aus den drei Raumdimensionen und der vierten Zeitdimension zusammen. In dieser Arbeit wurde ein Programm entwickelt, das aus einer Menge von übergebenen Trajektorien eine Trajektorie so anpasst, dass keine Konflikte mehr vorhanden sind. Um dieses Ziel zu erreichen, wird ein mit Konflikten behafteter Bereich mit einer generierten Trajektorie überbrückt. Die Generierung der Ausweichtrajektorie geschieht in konsistenter 4D-Planung. Das automatisierte Generieren der Ausweichtrajektorien auf Basis des 4D-Raums erlaubt das Modellieren des Lateral- und Vertikal-Ausweichens. Zusätzlich kann mit Hilfe der Zeitdimension auch das Variieren der Geschwindigkeit zur Vermeidung der Kollision abgebildet werden. Bei der automatischen Generation eröffnet sich die Möglichkeit, die Trajektorie zu optimieren: Zum Beispiel nach solchen Aspekten wie Treibstoffeffizienz oder Flugkomfort für Passagiere. Das entwickelte Programm generiert keine fliegbare Trajektorie, sondern diskretisiert lediglich den Suchraum um den Konfliktbereich und sucht nach einer möglichen Überbrückung für den Konfliktbereich. Als Ergebnis wird eine Liste mit Punkten im 4D-Raum ausgegeben. Diese Liste wird von der DLR-eigenen TrafficSim in eine fliegbare Trajektorie umgewandelt. Bei der Generierung der Ausweichtrajektorie ist zu beachten, dass TrafficSim mit geringerer Anzahl von Punkten bessere fliegbare Trajektorien generiert als bei höherer. Betreuer: blanke@welfenlab.de Mai 2012

September 2012

|

||||||

|

Bachelor thesis

Felix Haase

Prozedurale Multiskalen-Generierung von Planetenoberflächen

Beschreibungstext anzeigen

Ziel dieser Arbeit ist es Planetenoberflächen prozedural zu generieren. Dazu sollen insbesondere Fraktale verwendet werden die es ermöglichen sollen die Planeten auf verschiedenen Skalen mit unterschiedlichem Detailgrad darzustellen. Die zu entwickelnden Methoden sollen dabei klimatische Unterschiede bei der Generierung berücksichtigen. Neben der prozeduralen Generierung sollen auch verschiedene LOD (Level of Detail) Verfahren untersucht werden, um die Planeten in Echtzeit anzeigen und deren Detailgrad nahtlos anpassen zu können. Betreuer: Maximilian Klein Februar 2012

Juni 2012

|

||||||

|

Diploma thesis

Benjamin Fleischer

Welfenlab, IMS

Halbautomatische Segmentierung der knöchernen Strukturen des Kniegelenks in MRT Aufnahmen

Beschreibungstext anzeigen

Zuverlässige Segmentierung ist eine der wichtigsten und zugleich komplexesten Aufgaben in der modernen Volumen Analyse. Besonders im Bereich der Medizin sind bildgebende Verfahren heute ein integraler Bestandteil des klinischen Alltags geworden, was zur Folge hat das ein hoher Prozentsatz der Arbeitszeit auf die Nachbearbeitung bzw. Strukturfindung aufgewendet werden muss. Hier setzen (teil-) automatisierte, modellbasierte Verfahren an. Eine prominente Klasse der modellbasierten Segmentierungsverfahren ist der "Deformable Model" Ansatz. Grundidee ist die Verwendung eines initiales Modells, üblicherweise durch ein 3D Netz repräsentiert, welches in einem iterativen Verfahren an die zu findende Kontur angepasst wird und sich in jedem Schritt ausbreitet oder schrumpft, vergleichbar mit einem Ballon in den (lokal) Luft hingepumpt oder abgelassen wird. Ziel dieser Arbeit ist es, unter Verwendung des am Welfenlab entwickelte YaDiV Deformable Model Framework (YDMF) angepasste Modelle für die knöchernen Strukturen im Bereich des menschlichen Kniegelenks (Patella, Femur, Tibia) zu entwickeln. Als Volumendaten werden MRT-Aufnahmen zum Einsatz kommen, was eine zusätzliche Herausforderung an das Modell darstellt, da die Differenzierung von knöchernen Strukturen durch Weichgewebe in MRT-Aufnahmen erschwert wird.

Als erster Schritt soll ein Modell für die Patella entwickelt werden, welches mit anatomischen Landmarken versehen wird und durch eine lokal und global angepassten Expansions- bzw. Erosionskraft die Strukturfindung ermöglicht. Das Modell soll mit einer geringen Auswahl an Datensätzten trainiert und anschließend durch die Anwendung in neuen Aufnahmen evaluiert werden. Die gewonnen Erkenntnisse sollen dann für die Modellierung der Femur bzw. Tibia Modelle genutzt werden, bei denen die zusätzliche Herausforderung besteht, das hier oft nur eine Teilabdeckung im Aufnahmebereich besteht. Betreuer: Karl-Ingo Friese November 2011

Mai 2012

|

||||||

|

Seminarpaper

Oliver Ilnicki

Grid-based Fluid Simulations

Beschreibungstext anzeigen

Diese Seminararbeit beschäftigt sich mit den Grundlagen der Fluid-Simulation. Zunächst wird die Navier-Stokes Gleichung hergeleitet und darauf aufbauend werden verschiedene Lösungsansätze diskutierter mit dem Fokus auf dem Marker and Cell (MAC) Ansatz, der zwei versetze Gitter für die Drücke und Geschwindigkeiten im Fluid verwendet. Mittels finiter Differenzen wird dann eine Diskretisierung beschrieben die effizient das Fluid simulieren kann und dabei über einen Projektionsmechanismus die Inkompressibilität der Flüssigkeit gewährt.

Beschreibungstext verbergen

Betreuer: Maximilian Klein April 2012

Mai 2012

|

||||||

|

Bachelor thesis

Romeo Shuka

Leibniz Universität Hannover

3D-Textursynthese auf Grundlage zweidimensionaler Exemplare

Beschreibungstext anzeigen

Texturen dienen in der Computergrafik der Erzeugung detaillierter Oberflächenstrukturen ohne eine Verfeinerung der zugrundeliegenden Geometrie. 2D Texturen sind dabei oft Fotografien von Oberflächen, die beim Rendern auf die entsprechenden Oberflächen der Szene abgebildet werden. Sie erzeugen eine realistische Anmutung der Oberflächen von Objekten. Schnitte durch Objekte können mit dieser Methode allerdings nur schlecht visualisiert werden, da dies das Vorhandensein von 2D-Fotografien verschiedener Schnittrichtungen voraussetzt. 3D- oder Solid Textures können hier Abhilfe schaffen, da sie Informationen über die Detailstruktur des Inneren von Objekten geben. Sie werden üblicherweise als Voxeldatensatz, d.h. als Skalar- oder Vektorfeld auf einem ortsfesten, meist orthogonalen Raumgitter gespeichert. Moderne Grafikkarten bieten mittlerweile Hardware-Unterstützung für 2D-Texturen, so dass das Problem der Beschaffung von 3D-Texturen in letzter Zeit in den Mittelpunkt wissenschaftlicher Betrachtung gerückt wurde. Es wurden verschiedene funktionale Syntheseverfahren, als auch die Erzeugung auf Grundlage von Exemplaren, also zweidimensionalen Beispielbildern vorgeschlagen (Übersicht in [1]). In dieser Arbeit soll ein fortgeschrittenes Verfahren, z.B. basierend auf der Arbeit von Kopf et al. [2] entwickelt werden. Die Implementation soll in Java oder C++ erfolgen und die entstehenden 3D-Texturen in YaDiV geladen werden können. Speziell sollen als Exemplare Mikroskopien von Dualphasenstählen dienen, auf deren Besonderheiten Rücksicht genommen werden soll. Quellen [1] Pietroni et al. "Solid-Texture Synthesis: A Survey", IEEE Computer Graphics and Applications, 2010. [2] Kopf et al. "Solid Texture Synthesis from 2D Exemplars", ACM Trans. Graph., Vol. 26, No. 3, 2007, p. 2. Betreuer: blanke@welfenlab.de Januar 2012

Mai 2012

|

||||||

|

Junior thesis

Dennis Schridde

Implementation eines Kompressionsverfahrens für animierte Geometrie mittels Octrees

Beschreibungstext anzeigen

Das Entwickeln verteilter Simulationen erfordert neben adaptierter Algorithmen meist auch eine schnelle Anbindung der einzelnen Berechnungsknoten. Oft ist jedoch, trotz modernster Technologie, der Datentransfer zwischen den Knoten der Flaschenhals der verteilten Simulation. Ziel diese Arbeit ist es ein Verfahren, welches bisher zur Speicherung von 3D-Szenen verwendet wurde, zu adaptieren um eine echtzeitfähige Verwendung zu ermöglichen. Das Verfahren soll darauf in verteilten physikalischen Simulationen mit unterschiedlichen Technologien erprobt werden. Im Insitut sind neben den standard Ethernet-Anbindungen auch Infiniband-Anbindungen vorhanden, die einen Durchsatz von bis zu 20GBit/s erreichen und dabei enorm kurze Latenzzeiten im Bereich von Mikrosekunden versprechen. Betreuer: Rasmus Buchmann Februar 2012

April 2012

|

||||||

|

Bachelor thesis

Georg Konwisser

Development and Analysis of 2D and 3D Shape Matching and Shape Retrieval Algorithms using Laplace-Beltrami Spectra and Medial Axis Information

Beschreibungstext anzeigen

Written by Georg Konwisser (gekonwi AT gmail.com): Abstract Development of algorithms often focuses on one task: creating an algorithm which is better than another one doing the same task. The developer is thus compelled to answer the question: "Which algorithm is better?" The highly extendable modular framework and application I developed and implemented for this thesis can help developers of any classifying, matching or retrieval algorithms to answer this question with less implementation effort saving development time and cost. Overview In this work I will refer to the mentioned framework and application using the current project name AlCom (Algorithm Comparison). The main outline of this thesis is as follows:

November 2011

März 2012

|

||||||

|

Bachelor thesis

Nicola Hauke

Entwicklung eines modularen Clusterframeworks

Beschreibungstext anzeigen

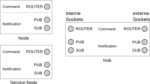

Ein Großteil der heutigen Anwendungen nutzen die parallele Ausführung von Programmen zum verringern der Rechenzeit. Die Parallelisierung erfolgt dabei meist in feinster Handarbeit und erfordert viel Zeit. Das Ziel dieser Arbeit ist die Erstellung eines Frameworks, dass die Parallelisierung von Programmen einerseits und den eigentlichen Entwicklungsprozess besser unterstüzen soll. Dabei soll das Framework mit einer Share-Nothing Architektur ein stabiles System bieten, dass ohne weiteren Aufwand die einzelnen Programmkomponenten parallel ausführen kann. Dazu soll das System modular gehalten werden, sodass die entwickelten Module leicht für jedermann verwendbar sind. Dafür werden klare Interfaces zur Kommunikation benötigt. Technisch wird das ganze über die ZeroMQ Bibliothek und einer Serialisierungsbibliothek wie Google Protocol Buffers implementiert werden. Dadurch wird es auch möglich sein Module in verschiedenen Programmiersprachen zu schreiben. Betreuer: Maximilian Klein November 2011

März 2012

|

||||||

|

Bachelor thesis

Karoline Busse

Implementierung einer parallelen partikelbasierten Fluidsimulation

Beschreibungstext anzeigen

Ein gängiges Modell zur Fluidsimulation stellen die Navier-Stokes Gleichungen dar. Diese nicht linearen partiellen Differentialgleichungen lassen sich mittels verschiedener Diskretisierungsmethoden lösen, von denen einige auf Grids oder Dreiecks-Meshs arbeiten. Andere verfolgen einen Partikelansatz, wie die Smoothed Particle Hydrodynamics (SPH) Methode. Das SPH Verfahren bietet dabei im Echtzeitbereich einige Vorteile. Aufgrund der Struktur des SPH Verfahrens ist es möglich interaktive Simulationen zu schaffen die auch visuell ansprechend sind.

Beschreibungstext verbergen

Die Berechnung der kontinuierlichen Parameter im SPH Verfahren geschieht über sogenannte Smoothing Kernels. Diese ermöglichen das effiziente Berechnen des Druckes in jedem Raumpunkt, wenn die Nachbarschaft eines jeden Partikels schnell bestimmt werden kann. Dies geschiet üblicherweise über ein Spacial Hashing mit dem es möglich ist Fluide mit einigen tausend Partikeln zu simulieren. In dieser Arbeit soll, unter der Verwendung von Grafikhardware, die mögliche Anzahl an Partikeln durch Parallelisierungstechniken erhöht werden. Dabei soll die Parallelisierung mit OpenCL umgesetzt werden, um auch mögliche Portierungen auf andere Plattformen zu erleichtern. Betreuer: Maximilian Klein Oktober 2011

Februar 2012

|

||||||

|

Diploma thesis

Anton Korol

Numerische Untersuchungen zum Dirac Operator auf Flächen.

August 2012

Februar 2012

|

||||||

| 2011 | ||||||

|

Diploma thesis

Andreas Tarnowsky

Head Position Invariant Gaze Tracking

Beschreibungstext anzeigen

Das Erfassen der Augenposition (oder Gaze Tracking), ist obwohl schon seit geraumer Zeit bekannt, noch kein verbreiteter Bestandteil heutiger immersiver VR-Umgebungen. Das ist teilweise auf die hohen Kosten kommerzieller Systeme zurückzuführen, speziell für Systeme die eine freie Kopfbewegung des Benutzers erlauben. Die vorliegende Arbeit untersucht, inwiefern sich auch mit erschwinglicher Hardware brauchbare Ergebnisse erzielen lassen. Dazu wird ein Prototyp konstruiert, der über eine Kamera die Reflektion verschiedener Markerpunkte auf dem Auge aufzeichnet und mittels eines selbst entwickelten Algorithmus den auf dem Bildschirm anvisierten Punkt ermittelt. Betreuer: Rasmus Buchmann Juli 2011

Dezember 2011

|

||||||

|

Junior thesis

Friedrich Krüger

Dynamische Erzeungung von Triangle Strips als Erweiterung des Marching Cube Verfahrens

Beschreibungstext anzeigen

Ein gängiges Verfahren zur indirekten Visualisierung von Volumendaten ist der Marching-Cube Algorithmus. Dabei wird jeweils ein (wandernder) Würfel über die Volumendaten gelegt und die Daten an dessen Eckpunkte ausgewertet. Je nach Eckpunktkonfiguration wird eine bereits vorberechnete Dreiecksmenge aus einer Lookup-Tabelle mit 256 Einträgen verwendet.

Ein Manko diese Verfahrens ist es, dass selbst bei kleinen Volumendaten sehr schnell große Dreiecksmengen entstehen können. Eine nachträgliche Reduzierung würde jedoch die Laufzeit beeinträchtigen. Ein Königsweg kann hier die Verwendung von sogenannten Triangle-Strips darstellen. Bei dieser optimierten Repräsentation von Dreiecksflächen lässt sich nicht nur der Memory-Footprint reduzieren, sondern auch die Darstellungsqualität (FPS) erheblich verbessern.

Daher ist es das Ziel dieser Studienarbeit, die Triangle Strips ohne Verlust der Performance dynamisch zu erzeugen.

Beschreibungstext verbergen

Betreuer: Karl-Ingo Friese September 2011

Dezember 2011

|

||||||

|

Junior thesis

Björn Bredthauer

Entwicklung eines Frameworks zur vereinfachten Softwareentwicklung fur den Cell Prozessor

Beschreibungstext anzeigen

Am Institut für Mensch-Maschine-Kommunikation wird aktuell ein Raum für Forschung in Bereich Virtual-Reality ausgestattet. In einer Reihe von studentischen Arbeiten sollen daher kleinere Anwendungen für die einzelnen Komponenten dieses VR-Raums entwickelt werden. Diese sollen in erster Linie für nachfolgende Arbeiten die Verwendung der vorhandenen Programmierschnittstellen demonstrieren. Es soll aber auch die Leistungsfähigkeit der Geräte und vor allem deren Grenzen analysiert Betreuer: Rasmus Buchmann Juni 2011

Dezember 2011

|

||||||

|

Diploma thesis

Natalya Obydenna

Parametrisierung von Flächen mit Hilfe des Ricci-Flusses

Beschreibungstext anzeigen

Der kontinuierliche Ricci Fluss ist eine parabolische partielle Differentialgleichung, welche einen Diffusionsvorgang für die Metrik einer Riemannschen Mannigfaltigkeit in Abhängigkeit der durch sie induzierten Ricci- Krümmung beschreibt. Die Metrik kann dadurch in eine vorgegebene Zielmetrik deformiert werden, welche zur ursprünglichen Metrik konform äquivalent ist. Betreuer: Alexander Vais Mai 2011

November 2011

|

||||||

|

Master thesis

Maximilian Hans Gerhard Klein

Local Refinement Methods for Fluid Simulation

Beschreibungstext anzeigen

Die Komplexität der Simulation dynamischer Prozesse in Echtzeit setzt enge Grenzen was die Problemgröße und die Genauigkeit von SImulationen selbst auf neuester Hardware angeht. Dabei ist es häufig gar nicht nötig, jede Lösung über einem Teilgebiet der Simulationsdomäne mit der selben Präzision zu berechnen. Häufig liefern adaptive Verfahren bei einer Verringerung der Freiheitsgrade bessere Ergebnisse. Diese Arbeit untersucht im Kontext der Fluidsimulation eine adaptive Fassung des Multigrid Algorithmus, der diese Eigenschaft nutzen soll um interaktive Fluidsimulation mit hoher Genauigkeit zu ermöglichen.

Dazu wird in einem sog. splitting Verfahren die Lösung der Fluidgleichungen in zwei Teilschritte zerlegt. Im ersten Schritt wird mit einem sog. semi-lagrangian Verfahren das (vorläufig divergenzbehaftete) Geschwindigkeitsfeld nach Einwirkung von verteilten Kräften, Randbedingungen und Advektion berechnet. Dieses wird dann in einem zweiten Schritt durch die Lösung eines geeigneten Poissonproblems mittels der Multigridmethode auf seinen divergenzfreien Anteil projiziert.

Beschreibungstext verbergen

Betreuer: Rasmus Buchmann April 2011

Oktober 2011

|

||||||

|

Bachelor thesis

Mohammad Ali Azizi-Sales

3D-Textursynthese für die Mikrostrukturmodellierung von Dualphasenstählen anhand von 2D-Metallographie

Beschreibungstext anzeigen

Wachsende Anforderungen im Bereich des Automobilbaus an den Werkstoff Betreuer: blanke@welfenlab.de Juni 2011

Oktober 2011

|

||||||

|

Bachelor thesis

Sergi Lazaro

Modelling of realistic Blood Vessel Geometry

Beschreibungstext anzeigen

With modern laser technology it has become possible to print living 3D organic structures like organs or muscles. Currently one of the main problems of this procedure is that the living material dies off during the printing process, therefor it becomes necessary to generate a supply.

The goal of this thesis is to analyse and construct the geometry of blood vessels. A vessel consists of an inner and outer diameter and may branch several times. A special focus will lie on the two end points, which function as input and output of the liquid supply system.

For this it is planned, to construct the basic structure as a connected graph generated by a Lindenmayer System. This graph is then understood as the medial axis of the vessel geometry. The inner and outer vessel diameter define the radius function. For the construction process, it should be possible to tweak these parameters.

Beschreibungstext verbergen

Betreuer: Karl-Ingo Friese Mai 2011

September 2011

|

||||||

|

Bachelor thesis

Magnus Adler

Leibniz Universität Hannover

Differentielle Wahrnehmungsschwellen in der Haptik

Beschreibungstext anzeigen

Es soll untersucht werden, wie sich die Wiederholrate der haptischen Darstellung auf die Qualität der Wahrnehmung auswirkt. Zu diesem Zweck werden unter Zuhilfename statistischer Methoden aus der Psychophysik Probandenversuche durchgeführt und analysiert.

Beschreibungstext verbergen

Betreuer: Rasmus Buchmann Mai 2011

September 2011

|

||||||

|

Bachelor thesis

Mona Lepke

Untersuchung zur Form- und Mustererkennung auf LC Displays bei benachbarten Farbwerten

Beschreibungstext anzeigen

In vielen Anwendungen wird Information als Farbwert kodiert. So stellt z.B. eine Wärmekamera Temperaturwerte in einer Falschfarbenskala dar. In der Medizin werden Intensitätswerte oft als Graustufen repräsentiert. Dabei können unterschiedliche physikalische Effekte kodiert werden, bei einem CT Bild stehen die Graustufen für die Schwächung der Röntgenenergie, bei einem MRT Bild für die Kernspinrelaxationszeit. Eine hohe Intensität wird dabei meist als Weiss, eine niedrige als Schwarz dargestellt, benachbarte Intensitäten erhalten ähnliche oder (bedingt durch den eingeschränkten Farbraum) sogar die gleiche Grauwerte.

Beschreibungstext verbergen

Oft übersehen wird dabei die Frage, ob die darstellbaren Farb- oder Grauwerte auch optisch auseinandergehalten werden können. Im DICOM Standard wurden dazu umfangreiche Untersuchungen durchgeführt und für die medizinische Befundung spezielle Monitore und Kalibrierungstechniken gefordert. Wie aber sieht es auf normalen LCD Monitoren aus, die z.B. in der präoperativen Planung verwendet werden? Hier setzt diese Arbeit an, in der Benutzertests zur Form- und Mustererkennung durchgeführt werden sollen. Dabei soll auf den Ergebnissen der Studienarbeit von Lara Toma aufgebaut werden, die ebenfalls am Welfenlab entstanden ist.Betreuer: Karl-Ingo Friese Mai 2011

September 2011

|

||||||

|

Seminarpaper

Jose Caravaca Fernandez

Leibniz Universität Hannover

Gradient evaluation on non-orthogonal meshes

Beschreibungstext anzeigen

The gradient of a scalar function is a well-known tool of vector analysis and routinely used to analyze images or results of simulations or to enhance volume visualization. In these applications, the gradient is usually not known but has to be approximated from the values of the function which are commonly given on a discrete set of points in some space. If these points lie on a regular, orthogonal grid, approximation of the gradient can be easily done using divided differences. In the case of non-orthogonal meshes, this is not as simple. In this seminar, several methods will be presented which can overcome this problem. Volume raycasting without (left) and with (right) gradient hinting.

Betreuer: blanke@welfenlab.de April 2011

Juli 2011

|

||||||

|

Junior thesis

Anton Korol

Laplace-Beltrami Operator für Punktwolken

Beschreibungstext anzeigen

In dieser Arbeit sollen die Eigenwerte und Eigenfunktionen des Laplace-Beltrami Operators für geschlossene zweidimensionale Mannigfaltigkeiten berechnet werden. Die Mannigfaltigeiten werden dabei durch eine Menge von Punkten repräsentiert. Da keine explizite Oberflächenbeschreibung vorliegt, können in diesem Fall keine herkömmlichen FEM-basierten Verfahren benutzt werden. In [1] wird ein Verfahren vorgeschlagen, welches direkt mit solchen punktbasierten Repräsentationen arbeitet ohne diese vorher in eine andere Repräsentation zu konvertieren. Im Rahmen der vorliegenden Studienarbeit soll neben der Erarbeitung der theoretischen Grundlagen das Verfahren aus [1] implementiert und in ein vorgegebenes C++ Framework eingebunden werden. Das implementierte Verfahren soll an einer Menge von Beispielobjekten mit Ausblick auf die Anwendung in der Gestalterkennung erprobt werden. [1] Yang Liu, Balakrishnan Prabhakaran, Xiaohu Guo, "Point-Based Manifold Harmonics," Technical Report, UTDCS-15-09, University of Texas at Dallas, 2009 April 2011

Juli 2011

|

||||||

|

Bachelor thesis

Alexander Lanin

Gestenerkennung mit einem Datenhandschuh

Beschreibungstext anzeigen

Am Institut für Mensch-Maschine-Kommunikation wird aktuell ein Raum für Forschung in Bereich Virtual-Reality ausgestattet. In einer Reihe von studentischen Arbeiten sollen daher kleinere Anwendungen für die einzelnen Komponenten dieses VR-Raums entwickelt werden. Diese sollen in erster Linie für nachfolgende Arbeiten die Verwendung der vorhandenen Programmierschnittstellen demonstrieren. Es soll aber auch die Leistungsfähigkeit der Geräte und vor allem deren Grenzen analysiert Eine dieser Komponenten ist ein Datenhandschuh, der die Gelenkstellungen einer Hand erfassen kann. Mithilfe dieses Geräts soll ein System entwickelt werden, das die Steuerung von Anwendungen durch Gesten ermöglichen soll. Dazu soll im Rahmen dieser Arbeit die Ansteuerung des Datenhandschuhs und dessen Einbindung in ein bestehendes Framework realisiert werden. Die Möglichkeit der Erkennung einfacher Gesten soll dabei aufgezeigt werden. Betreuer: Alexander Vais Januar 2011

Mai 2011

|

||||||

|

Master thesis

Matthias Becker

Welfenlab + Kiefer-, Mund und Geschitschirurgie der MHH

Modellbasierte Orbita Segmentierung und die automatisierte Bestimmung anatomisch relevanter Parameter

Beschreibungstext anzeigen

Der Begriff Segmentierung beschreibt die Auswahl von Voxeln in einem Volumendatensatz entsprechend einem vom Benutzer gewählten Homogenitätskriterium. Ein einfaches Verfahren könnte z.B. alle Voxel zwischen einer unteren oder oberen Intensitätsschranke segmententieren (Min-Max-Verfahren). Sollen komplexere Formen erkannt werden, kommen meist modellbasierte Verfahren zum Einsatz. Ein Beispiel für eine solche, komplexe Form, stellt die knöcherne Augenhöhle (Orbita) dar. Ziel dieser Masterarbeit war es, modellbasierte Verfahren anhand des klinisch relevanten Beispiels der Orbita-Segmentierung zu untersuchen. Die entwickelten Algorithmen sind jedoch allgemeiner und auch für andere Anwendungsfälle einsetzbar. Ein Hauptaugenmerk lag dabei auf dem Deformable Model Ansatz. Dabei wird ein zur gesuchten Segmentkontur topologisch äquivalentes Startmodell schrittweise "aufgeblasen" und durch geeignete innere oder äußere Parameter (Formerhaltung, Gradienten, ...) gebremst. Zur Demonstration des Verfahrens wurde ein Modul für die von Karl-Ingo Friese geschriebene Software YaDiV entwickelt werden, das die Visualisierung und Kontrolle der Evolutionssparameter in jedem Schritt erlaubt. In der Ausarbeitung wurde der Einfluss unterschiedlicher Parametergewichtungen untersucht. Ein weiteres Ziel dieser Arbeit bestand in der automatisierten Bestimmung anatomisch interessanter Punkte und Größen (Winkel, Abstände, etc.) und einer Analyse der Segmentgüte. Betreuer: Karl-Ingo Friese Oktober 2010

April 2011

|

||||||

|

Seminarpaper

Pawel Gardzinski

Welfenlab

Exact and Approximate Geodesics on Meshes

Beschreibungstext anzeigen

The computation of geodesic paths and distances on triangle meshes is a common operation in many computer graphics applications. I will present several practical algorithms for computing such geodesics from a source point to one or all other points efficiently.

First, I will describe an implementation of the exact “single source, all destination” algorithm presented by Mitchell, Mount, and Papadimitriou (MMP). I will show that the algorithm runs much faster in practice than suggested by worst case analysis.

I will also show an algorithm (by V. And T. Surazhsky, D. Kirsanov, Steven J. Gortler and H. Hoppe) extended with a merging operation to obtain computationally efficient and accurate approximations with bounded error.

Finally, to compute the shortest path between two given points, I will show how the authors used a lower-bound property of their approximate geodesic algorithm to efficiently prune the frontier of the MMP algorithm, thereby obtaining an exact solution even more quickly.

Beschreibungstext verbergen

Betreuer: Alexander Vais Februar 2011

|

||||||

|

Junior thesis

Benjamin Fleischer

IMS + Welfenlab

Entwicklung eines Moduls zur automatisierten Bestimmung der Kniegelenkskinematik und -biomechanik durch dreidimensionale in vivo-Analyse mittels MRT

Beschreibungstext anzeigen

Durch nichtinvasive Verfahren gewonnene 3D-Bilddaten finden auch im Bereich der Kniegelenkserkrankungen und -verletzungen eine immer bereitere Anwendung. Durch Techniken wie dem (offenen) Up-Right MRT ist es möglich, funktionelle Aufnahmen in unterschiedlichen Gelenkstellungen mit und ohne (natürliche) Belastung durchzuführen.

Von besonderem klinischen Interesse ist die Bestimmung biomechanischer Parameter, wie z.B. dem Patello-femoralen Winkel zwischen der Kniescheibe und der Hauptachse des Oberschenkelknochens. Dabei wird das Ziel verfolgt, bestehende oder zukünftige nicht-physiologische Verhältnisse besser

Beschreibungstext verbergen